強化学習アルゴリズム整理

久しぶりにPolicy Gradientやろうとしたら全部忘れていた

DQN

アルゴリズム

- とりあえずプレイアウトして

をreplay memoryに保存する

と、その

ステップ後の

を取り出してきて、後者の価値を古いネットワークで推定し、そこからrewardを逆算した前者の価値に近づけるように、新しいネットワークを学習させる

- 数iter学習したら古いネットワークを新しくする

いいところ

- replay memoryに保存してまとめてとってくるので、まとめて推論できて、高速だしsample efficient

Policy Gradient

アルゴリズム

- 期待報酬

を最大化するように学習する

は確率的

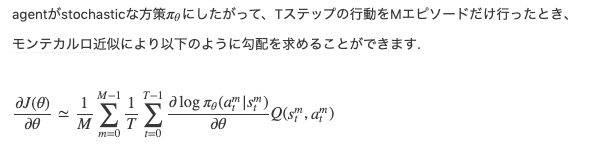

- この勾配はpolicy gradient theoremによって求まる

sykwerくんの記事が優秀

いいところ

- まあこれも

エピソード分の推論は同時にできるしそんなにスピード悪くなさそう

- DQNに比べて何がいいのかわからんな

MCTS

アルゴリズム

- 未展開ノードについたらその評価を推論して、そこまでのノードの評価をupdateする

- visit回数に応じて、より強いpolicyを構築し、それに合わせるように学習する

- スコアは相対的なものにする